LambdaLR#

- class torch.optim.lr_scheduler.LambdaLR(optimizer, lr_lambda, last_epoch=-1)[來源]#

設定初始學習率。

每個引數組的學習率被設定為初始學習率乘以給定的函式。當 last_epoch=-1 時,將初始學習率設定為 lr。

- 引數

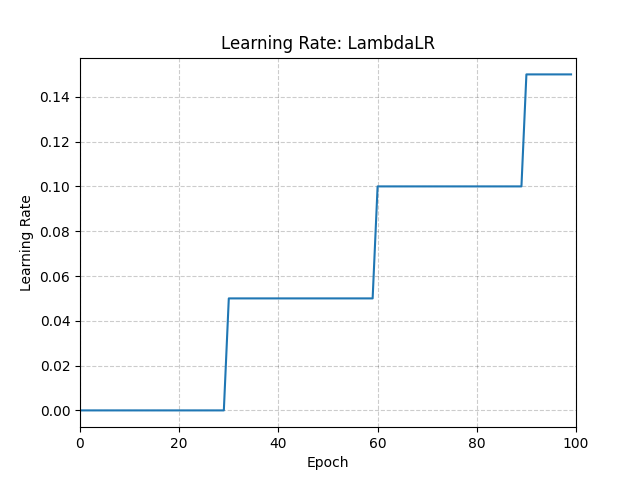

示例

>>> # Assuming optimizer has two groups. >>> num_epochs = 100 >>> lambda1 = lambda epoch: epoch // 30 >>> lambda2 = lambda epoch: 0.95**epoch >>> scheduler = LambdaLR(optimizer, lr_lambda=[lambda1, lambda2]) >>> for epoch in range(num_epochs): >>> train(...) >>> validate(...) >>> scheduler.step() >>> >>> # Alternatively, you can use a single lambda function for all groups. >>> scheduler = LambdaLR(opt, lr_lambda=lambda epoch: epoch // 30) >>> for epoch in range(num_epochs): >>> train(...) >>> validate(...) >>> scheduler.step()

- load_state_dict(state_dict)[來源]#

載入排程器的狀態。

在儲存或載入排程器時,請確保同時儲存或載入最佳化器的狀態。

- 引數

state_dict (dict) – 排程器狀態。應該是呼叫

state_dict()後返回的物件。