ChainedScheduler#

- class torch.optim.lr_scheduler.ChainedScheduler(schedulers, optimizer=None)[原始碼]#

將一系列學習率排程器連結在一起。

接受一系列可連結的學習率排程器,並在一次呼叫 step() 時連續呼叫它們的 step() 函式。

- 引數

schedulers (sequence) – 連結的排程器序列。

optimizer (Optimizer, optional) – 封裝的最佳化器。預設值:None。

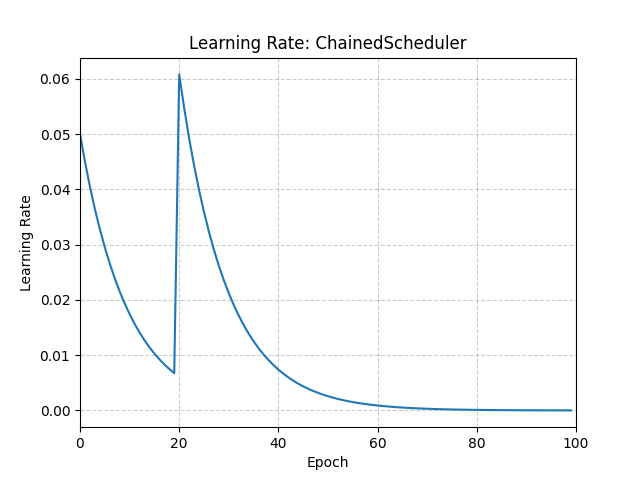

示例

>>> # Assuming optimizer uses lr = 0.05 for all groups >>> # lr = 0.05 if epoch == 0 >>> # lr = 0.0450 if epoch == 1 >>> # lr = 0.0405 if epoch == 2 >>> # ... >>> # lr = 0.00675 if epoch == 19 >>> # lr = 0.06078 if epoch == 20 >>> # lr = 0.05470 if epoch == 21 >>> scheduler1 = ConstantLR(optimizer, factor=0.1, total_iters=20) >>> scheduler2 = ExponentialLR(optimizer, gamma=0.9) >>> scheduler = ChainedScheduler([scheduler1, scheduler2], optimizer=optimizer) >>> for epoch in range(100): >>> train(...) >>> validate(...) >>> scheduler.step()

- load_state_dict(state_dict)[原始碼]#

載入排程器的狀態。

- 引數

state_dict (dict) – 排程器狀態。應該是一個從呼叫

state_dict()返回的物件。